今回は、画像生成AI Stable Diffusionの拡張機能である、ControlNetで使用できる最もおすすめのモデルを4つを紹介します。

ControlNetでは、日々様々なモデルがリリースされていますが、ControlNetインストールしたら最初に合わせて導入しておきたいモデルとして以下の4つをピックアップしました。

- openpose

- depth(Depth map library and poser)

- reference_only

- tile_resample

構図のコントロールやディティールの追加など、基本的な機能でありつつも、画像のクオリティを大幅に向上させることができる機能となっていますので、ぜひ試してみてください。

- ControlNetで必須となるおすすめのモデル

- 各モデルの効果

- 各モデルの導入方法と使用方法

ControlNet本体の導入方法についても、以下の記事で解説していますので、あわせてご覧ください。

また、当ブログのStable Diffusionに関する記事を以下のページでまとめていますので、あわせてご覧ください。

Stable Diffusionの導入方法から応用テクニックまでを動画を使って習得する方法についても以下のページで紹介しています。

openpose

まず1つ目に紹介するのはopenposeです。

おそらくControlNetの中でも最もよく利用されているポーズを指定することができるモデルです。

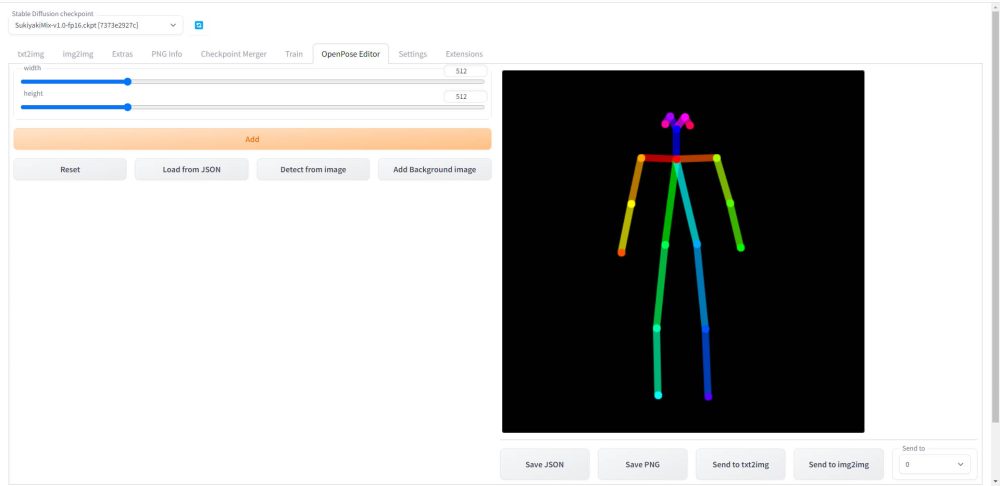

OpenPoseEditorというツールと連携させることで、以下のようにWebUI上で棒人間をマウスで操作してポーズを作成することが可能になります。

openposeという骨格検出が可能な機械学習モデルを使い、棒人間のポーズを読み込み、その情報をStable Diffusionで読み込んで画像を生成します。

実際に画像左のようなポーズを作成し、それを元にStable Diffusionで画像生成を行った結果です。

このように、openposeを使用することでキャラクターのポーズを自在にコントロールできるようになります。

openposeの詳細な使い方については、以下の記事で解説しています。

depth(Depth map library and poser)

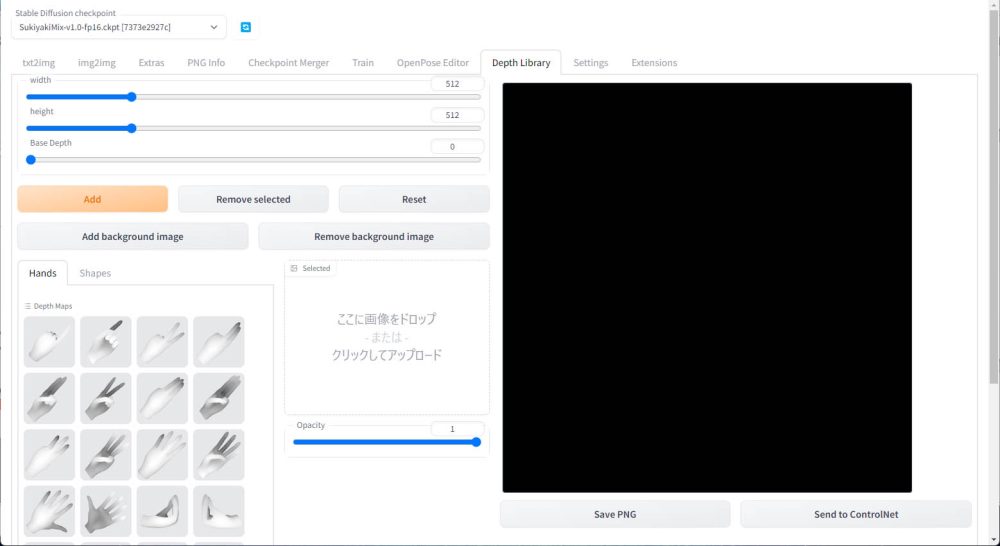

depth(Depth map library and poser)は深度情報を使って、Stable Diffusionで生成される人物の手のポーズをコントロールします。

depth(Depth map library and poser)をWebUIのインストールすると、以下のようにWebUI上でキャラクターのハンドポーズを選択して配置できるようになります。

ハンドポーズを指定すると、そのポーズの深度情報を読み込み、生成画像の配置した位置に適用されます。

実際に画像生成時にdepthを適用すると、失敗した手の部分だけを指定したハンドポーズを適用して修復することができます。

depthの詳細な使い方については、以下の記事で解説しています。

reference_only

reference_onlyは一枚の画像を元に類似の画像を生成するモデルです。

通常、ある画像を元に違うポーズやアングルから撮影したような画像を生成するにはLoRA(Low-Rank Adaptation)というモデルを局所的に追加学習する仕組みを利用します。

しかし、LoRAでの追加学習には、元となるキャラクターやコスチューム、風景など模倣させたい特徴を含んだ画像を最低20枚以上用意する必要があります。

しかし、ControlNetのモデルであるreference_onlyを使用すると、たった一枚の画像から、その特徴を模擬した画像が生成できます。

以下がサンプルとなる元画像です。(東北ずん子データセット)

そして以下がreference_onlyを使って生成した画像です。元画像のキャラクターの髪型や色、服装などの特徴が継承されているのが確認できます。

このように、reference_onlyを使用すると、手軽に類似の画像を手軽に量産することが可能です。

学習元となるデータを大量に用意しなければならないLoRAによる追加学習でも、reference_onlyを使用することにより学習用のデータセットを簡単に生成することもできます。

reference_onlyの詳細な使い方については、以下の記事で解説しています。

tile_resample

tile_resampleは、元の絵のタッチや構図を維持したままアップスケールすることができるモデルです。

Stable Diffusionで使用できるアップスケーラと言えば、hires.fixやDetail Tweaker LoRAなどが良く使われるかと思います。tile_resampleはこれらのアップスケーラよりも元の絵の特徴を維持したまま、大幅に書き込み量を増やすことが可能です。

以下がtile_resampleを適用する前と後の比較です。

このように、元の画像の良さを維持しつつディティールを追加したい場合におすすめです。

tile_resampleの詳細な使い方については、以下の記事で解説しています。

Stable Diffusionのテクニックを効率よく学ぶには?

カピパラのエンジニア

カピパラのエンジニアStable Diffusionを使ってみたいけど、ネットで調べた情報を試してもうまくいかない…

そんな時は、操作方法の説明が動画で見られるUdemyがおすすめだよ!

動画学習プラットフォームUdemyでは、画像生成AIで高品質なイラストを生成する方法や、AIの内部で使われているアルゴリズムについて学べる講座が用意されています。

Udemyは講座単体で購入できるため安価で(セール時1500円くらいから購入できます)、PCが無くてもスマホでいつでもどこでも手軽に学習できます。

Stable Diffusionに特化して学ぶ

Stable Diffusionに特化し、クラウドコンピューティングサービスPaperspaceでの環境構築方法から、モデルのマージ方法、ControlNetを使った構図のコントロールなど、中級者以上のレベルを目指したい方に最適な講座です。

画像生成AIの仕組みを学ぶ

画像生成AIの仕組みについて学びたい方には、以下の講座がおすすめです。

画像生成AIで使用される変分オートエンコーダやGANのアーキテクチャを理解することで、よりクオリティの高いイラストを生成することができます。

まとめ

今回はControlNetを導入したら必ず入れておきたいモデル4選を紹介しました。

私自身も良く使用しており、どれもControlNetを使用する上では鉄板となるモデルばかりですので、ぜひ実際の効果を確認してみてください。

ControlNetの使用方法については、以下の記事で解説していますので、あわせてご覧ください。

また、ハイクオリティな画像を生成するためのプロンプトを、自然言語モデルを使って生成する方法について、以下の記事で解説していますので、あわせてご覧ください。

それでは、また次の記事でお会いしましょう。

コメント