ControlNetで使用できるプリプロセッサ、tile_resampleを使って、元の画像の絵柄を保ったまま書き込み量を増やす方法について解説します。

Hires.fix等でアップスケールする際に、絵柄が変わってしまうといった問題も解決できますので、ぜひ活用してみてください。

また、当ブログのStable Diffusionに関する記事を以下のページでまとめていますので、あわせてご覧ください。

Stable Diffusionの導入方法から応用テクニックまでを動画を使って習得する方法についても以下のページで紹介しています。

Stable Diffusionとは

Stable Diffusion(ステーブル・ディフュージョン)は2022年8月に無償公開された描画AIです。ユーザーがテキストでキーワードを指定することで、それに応じた画像が自動生成される仕組みとなっています。

NVIDIAのGPUを搭載していれば、ユーザ自身でStable Diffusionをインストールし、ローカル環境で実行することも可能です。

(出典:wikipedia)

Stable DiffusionのWeb UI AUTOMATIC1111

AUTOMATIC1111はStable Diffusionをブラウザから利用するためのWebアプリケーションです。

AUTOMATIC1111を使用することで、プログラミングを一切必要とせずにStable Diffusionで画像生成を行うことが可能になります。

Web UI AUTOMATIC1111のインストール方法

Web UIであるAUTOMATIC1111を実行する環境は、ローカル環境(自宅のゲーミングPCなど)を使用するか、クラウドコンピューティングサービスを利用する2通りの方法があります。

以下の記事ではそれぞれの環境構築方法について詳し解説していますので、合わせてご覧ください。

ControlNetのインストール

tile_resampleはControlNetで使用できる機能となりますので、まずはベースのControlNetをインストールする必要があります。

インストール手順は以下の記事で解説しています。

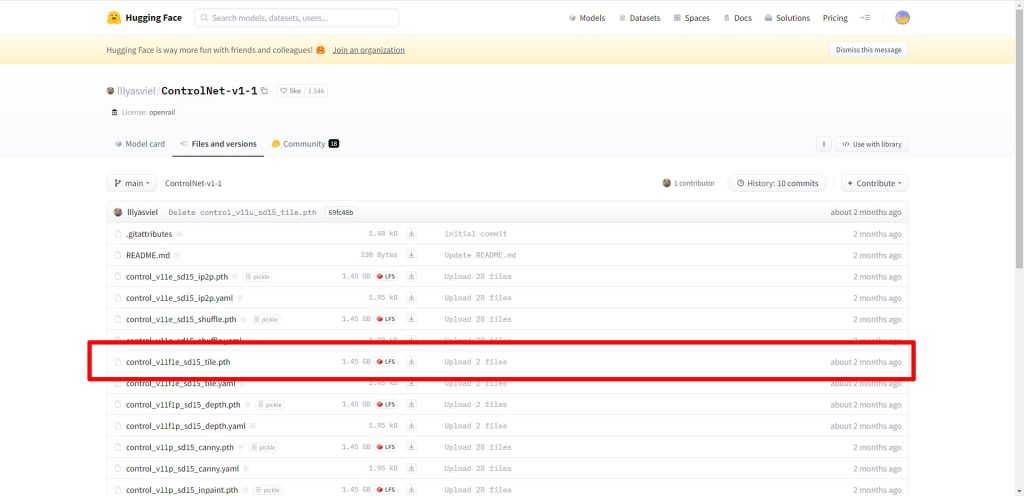

モデルのダウンロード

今回、ControlNetで使用するモデル、tileをダウンロードします。

以下のページにアクセスしてください。

ファイルの一覧から、control_v11f1e_sd15_tile.pthをダウンロードします。

ダウンロードしたモデルを以下のディレクトリに配置してください。

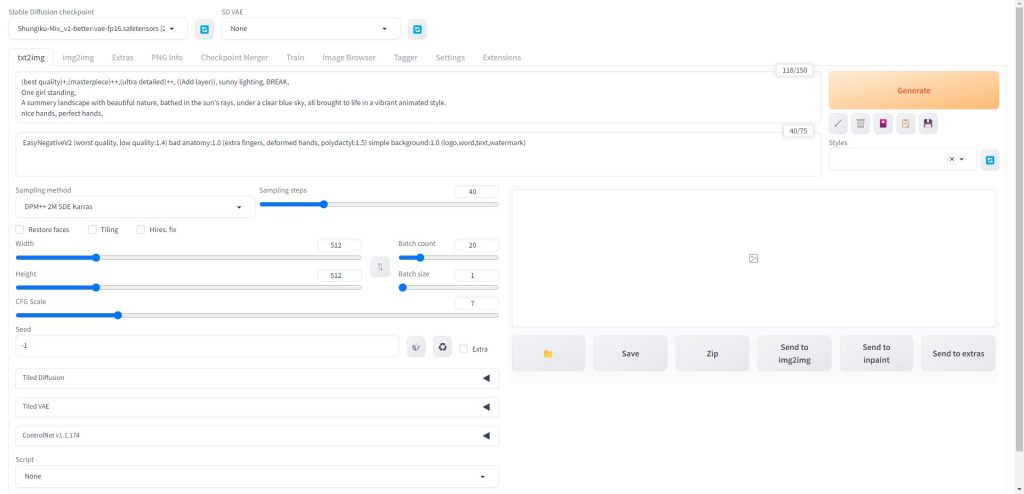

tile_resampleを使用する手順

ここからは、実際にtile_resampleを使用するための手順を解説していきます。

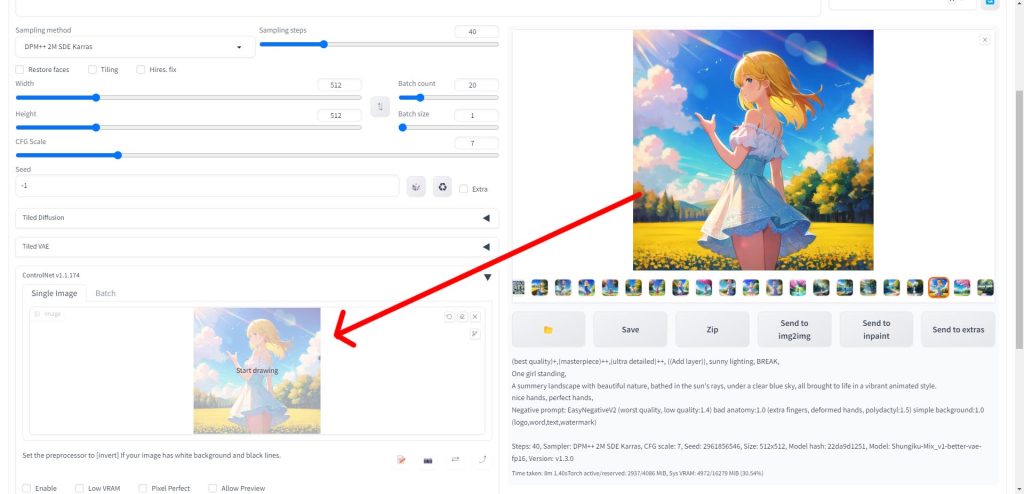

まず、Web UIを起動したら、通常通りプロンプトとパラメータを入力して画像を生成します。

プロンプトの作成が難しいと思われている方には、AIでプロンプトを自動生成するのがおすすめです。「StableDiffusionのプロンプト(呪文)を自然言語処理モデルGPT-3(Catchy)で自動生成する方法」で詳細を解説しています。

画像生成が完了したら、Web UIのControlNetの項目をクリックして展開します。

ControlNetのSingle Imageの項目に、先ほど生成した画像の中からベースとして使用したい画像をドラッグ&ドロップで配置します。

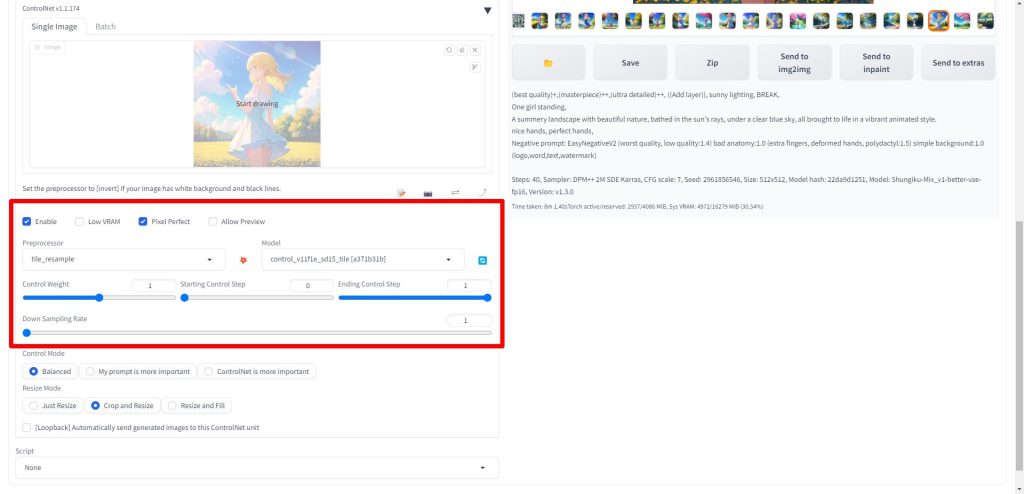

ControlNetのパラメータを設定します。Preprocessorをtile_resampleに設定します。Modelを先ほどダウンロードしたcontrol_v11f1e_sd15_tileに設定します。Down Sampling Rateは任意で設定してください。

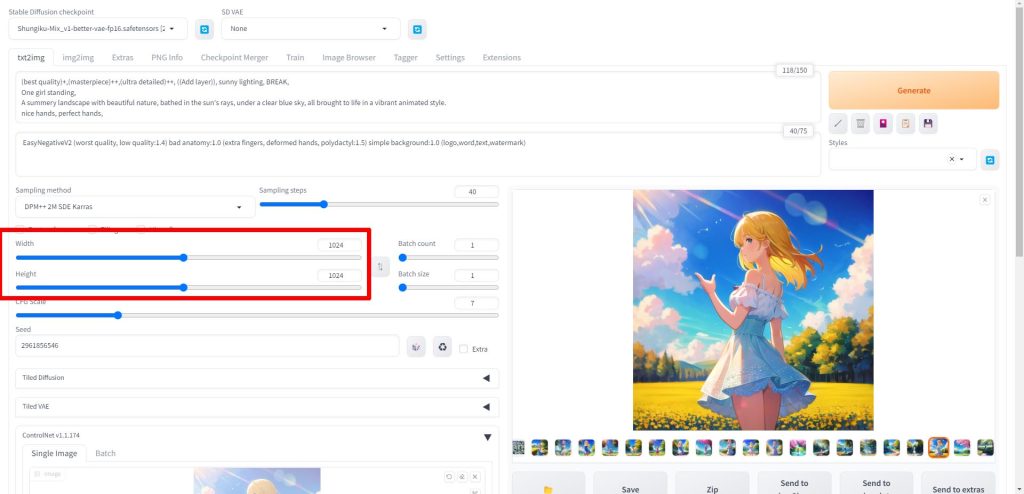

ControlNetの設定が終わったら、最後に画像サイズの設定を行います。

今回はベース画像が512*512ですので、WidthとHeightをそれぞれ1024に設定しました。

画像サイズの設定についてはHires.fixを使っても問題ありません。

Hires.fixの使い方については以下の記事で解説しています。

以上で設定は完了です。Generateをクリックして画像を生成してください。

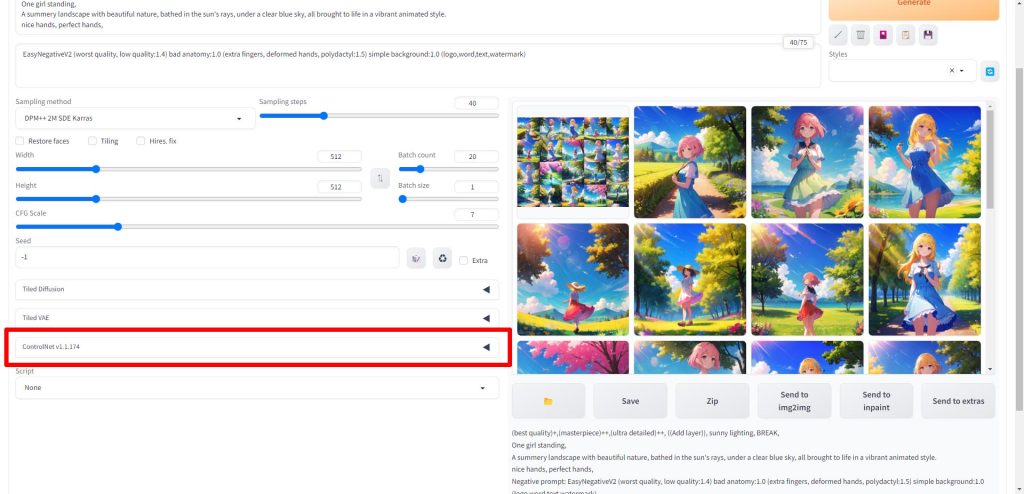

実行結果

tile_resampleを使って画像生成を行った結果が以下となります。

元画像

こちらがtile_resampleを使用していない元画像です。画像サイズは512*512です。

tile_resampleでアップスケールした画像

tile_resampleを使って再描画した画像が以下となります。

画像サイズは2倍の1024*1024に拡大され、書き込み量も大幅に増えて高精細になりました。

Stable Diffusionのテクニックを効率よく学ぶには?

カピパラのエンジニア

カピパラのエンジニアStable Diffusionを使ってみたいけど、ネットで調べた情報を試してもうまくいかない…

そんな時は、操作方法の説明が動画で見られるUdemyがおすすめだよ!

動画学習プラットフォームUdemyでは、画像生成AIで高品質なイラストを生成する方法や、AIの内部で使われているアルゴリズムについて学べる講座が用意されています。

Udemyは講座単体で購入できるため安価で(セール時1500円くらいから購入できます)、PCが無くてもスマホでいつでもどこでも手軽に学習できます。

Stable Diffusionに特化して学ぶ

Stable Diffusionに特化し、クラウドコンピューティングサービスPaperspaceでの環境構築方法から、モデルのマージ方法、ControlNetを使った構図のコントロールなど、中級者以上のレベルを目指したい方に最適な講座です。

画像生成AIの仕組みを学ぶ

画像生成AIの仕組みについて学びたい方には、以下の講座がおすすめです。

画像生成AIで使用される変分オートエンコーダやGANのアーキテクチャを理解することで、よりクオリティの高いイラストを生成することができます。

まとめ

今回はtile_resampleの使い方を解説しました。

以前にもLoRAを使って書き込み量を増やす方法などについて解説しましたが、今回のtile_resampleはそれらに比べて、元の絵柄が変化しにくいというメリットがあります。

他のアップスケーラとの併用も可能ですので、色々な組み合わせを試してみてください。

また、以下の記事で効率的にPythonのプログラミングスキルを学べるプログラミングスクールの選び方について解説しています。最近ではほとんどのスクールがオンラインで授業を受けられるようになり、仕事をしながらでも自宅で自分のペースで学習できるようになりました。

スキルアップや副業にぜひ活用してみてください。

スクールではなく、自分でPythonを習得したい方には、いつでもどこでも学べる動画学習プラットフォームのUdemyがおすすめです。

講座単位で購入できるため、スクールに比べ非常に安価(セール時1200円程度~)に学ぶことができます。私も受講しているおすすめの講座を以下の記事でまとめていますので、ぜひ参考にしてみてください。

それでは、また次の記事でお会いしましょう。

コメント