これまで、当ブログではStable Diffusion 1.5をベースとした様々なマージモデルを紹介してきました。

今回は、Stable Diffusionの開発元である、Stability AIが公開している後継バージョンのStable Diffusion 2.1をWebUI上で動作させる方法について解説します。

旧バージョン1.5から大幅にクオリティが向上していますので、ぜひ試してみてください。

また、当ブログのStable Diffusionに関する記事を以下のページでまとめていますので、あわせてご覧ください。

Stable Diffusionの導入方法から応用テクニックまでを動画を使って習得する方法についても以下のページで紹介しています。

Stable Diffusionとは

Stable Diffusion(ステーブル・ディフュージョン)は2022年8月に無償公開された描画AIです。ユーザーがテキストでキーワードを指定することで、それに応じた画像が自動生成される仕組みとなっています。

NVIDIAのGPUを搭載していれば、ユーザ自身でStable Diffusionをインストールし、ローカル環境で実行することも可能です。

(出典:wikipedia)

Stable DiffusionのWeb UI AUTOMATIC1111

AUTOMATIC1111はStable Diffusionをブラウザから利用するためのWebアプリケーションです。

AUTOMATIC1111を使用することで、プログラミングを一切必要とせずにStable Diffusionで画像生成を行うことが可能になります。

Web UI AUTOMATIC1111のインストール方法

Web UIであるAUTOMATIC1111を実行する環境は、ローカル環境(自宅のゲーミングPCなど)を使用するか、クラウドコンピューティングサービスを利用する2通りの方法があります。

以下の記事ではそれぞれの環境構築方法について詳し解説していますので、合わせてご覧ください。

Stable Diffusion 2.1のインストール

Stable Diffusion 2.1のモデルをWebUIの環境にインストールする方法について解説します。

環境によって異なりますので、ご利用の環境の項目を参考に進めてください。

ローカル環境

ローカル環境の場合は以下のディレクトリにモデルを配置します。

以下の2つのファイルを手動でダウンロードし、配置してください。

https://huggingface.co/stabilityai/stable-diffusion-2-1/resolve/main/v2-1_768-ema-pruned.safetensors

https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yamlPaperspace

Paperspaceの場合は、以下のコマンドをJupyter Notebook追記します。

%cd /notebooks/stable-diffusion-webui/models/Stable-diffusion

!wget https://huggingface.co/stabilityai/stable-diffusion-2-1/resolve/main/v2-1_768-ema-pruned.safetensors

!wget https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yamlJupyter Notebookは以下のPaperspace用ものを使用してください。

Jupyter Notebookの詳細な使用方法は以下の記事で解説しています。

Google Colaboratory

Google Colaboratoryの場合は、以下のコマンドをJupyter Notebook追記します。

!wget https://huggingface.co/stabilityai/stable-diffusion-2-1/resolve/main/v2-1_768-ema-pruned.safetensors -O /content/stable-diffusion-webui/models/Stable-diffusion/v2-1_768-ema-pruned.safetensors

!wget https://raw.githubusercontent.com/Stability-AI/stablediffusion/main/configs/stable-diffusion/v2-inference-v.yaml -O /content/stable-diffusion-webui/models/Stable-diffusion/v2-1_768-ema-pruned.yamlGoogle Colab用のJupyter Notebookの使用方法は、以下の記事で解説しています。

WebUIの設定を変更する

Stable Diffusion 2.1をそのまま実行すると以下のようにエラーが発生します。

このエラーを回避するため、WebUIの設定を変更します。

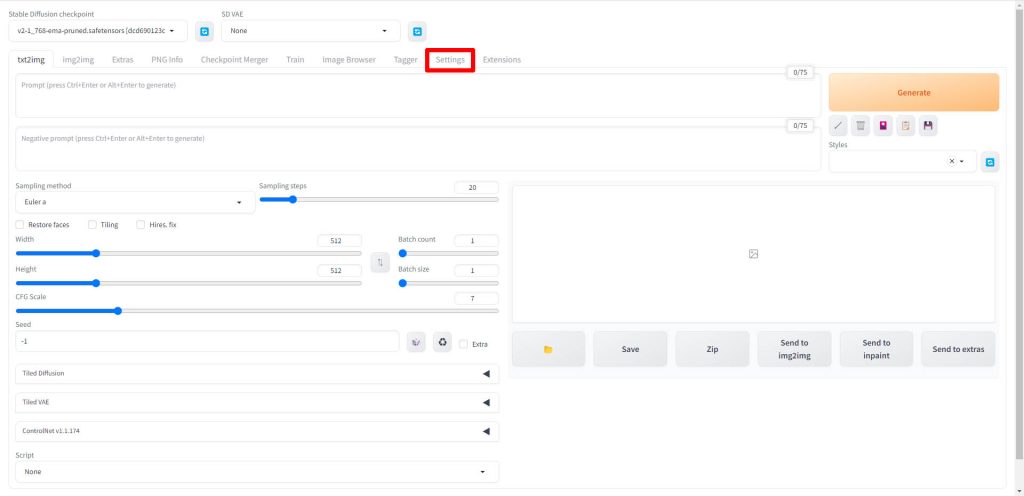

WebUIが起動したら、Settingsタブをクリックします。

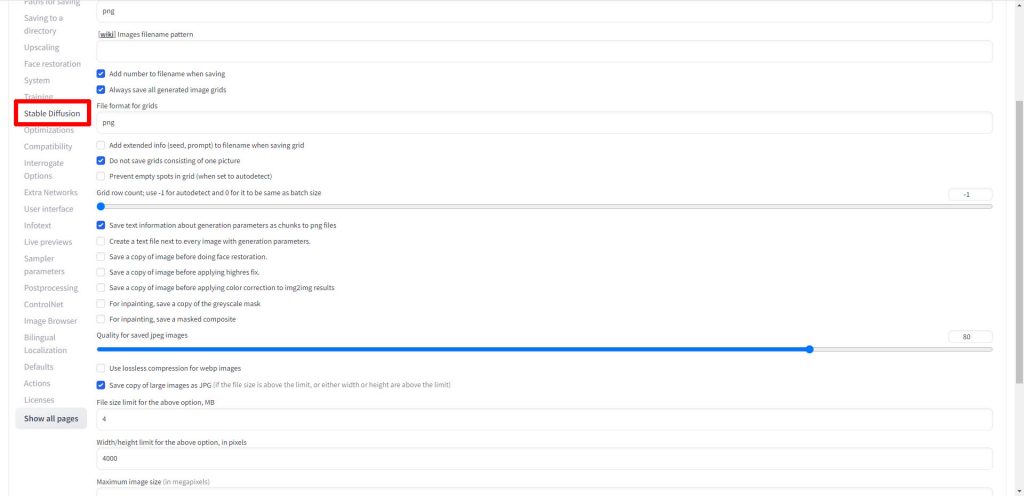

画面左のメニューから、Stable Diffusionをクリックします。

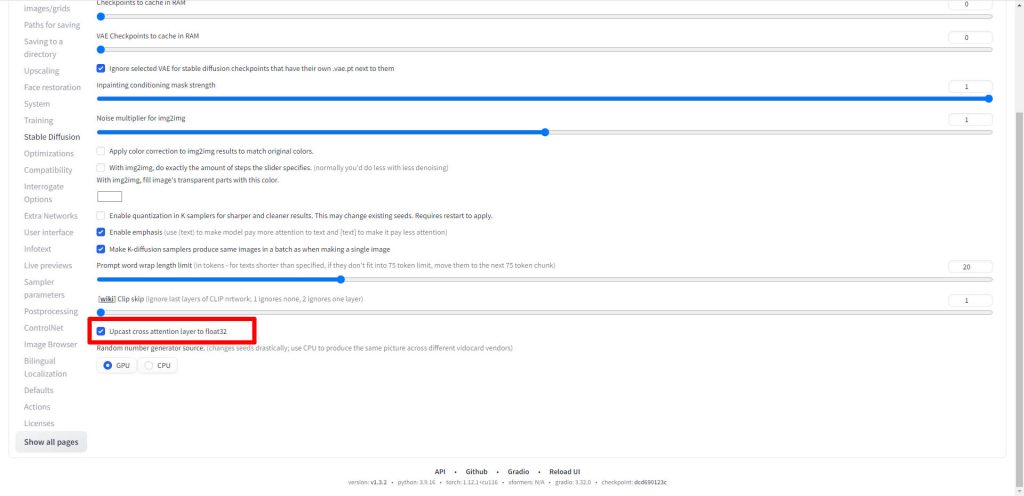

画面を下にスクロールし、Upcast cross attention layer to float32のチェックボックスをONにします。

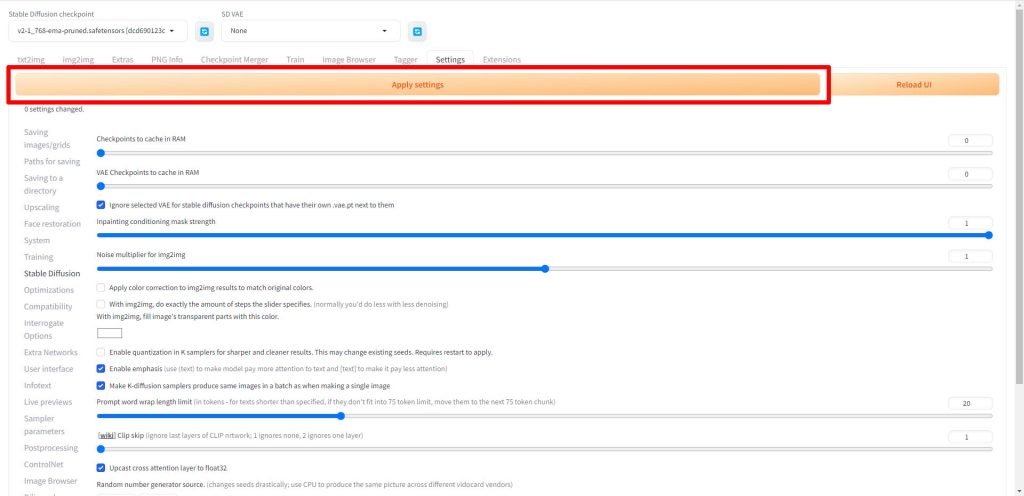

Apply settingsをクリックし、設定を反映します。

以上で設定は完了です。

WebUIを再起動してください。

画像生成を実行する

WebUIを再起動したら、画像を生成します。

モデルを選択する

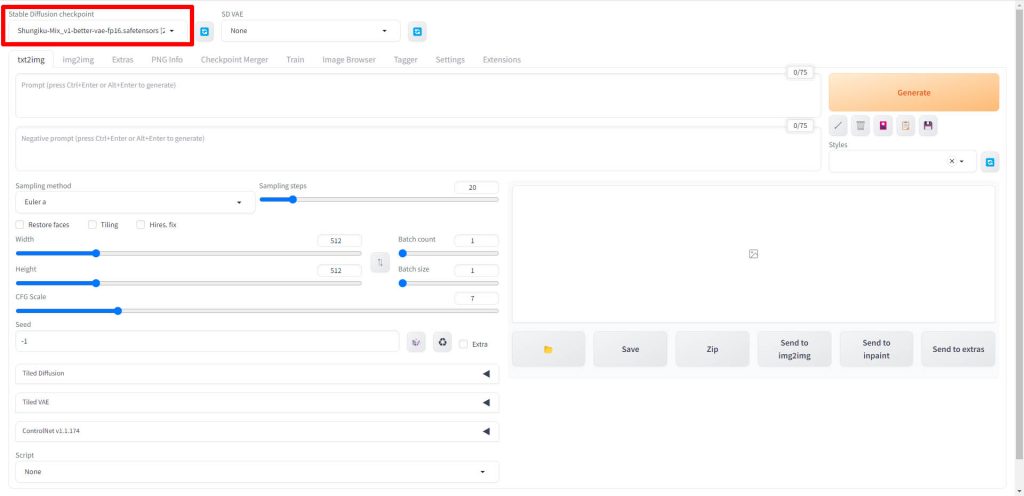

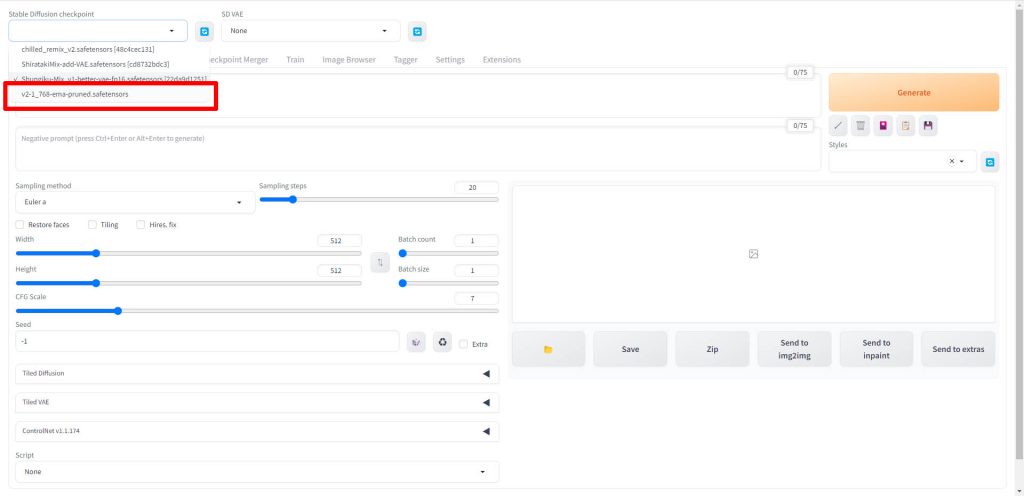

画面左上のStable Diffusion checkpointモデル選択ドロップダウンリストをクリックします。

モデルの一覧から、v2-1_768-ema-pruned.safetensorsを選択します。

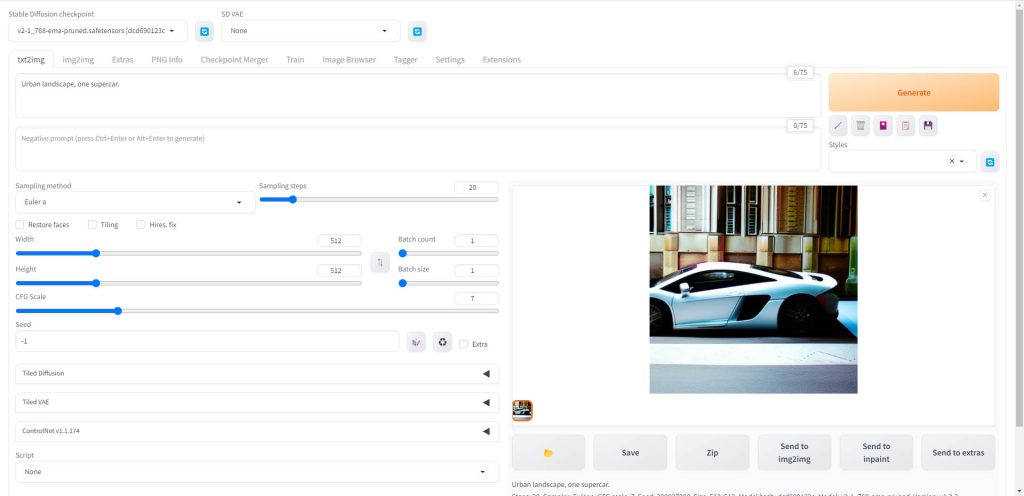

プロンプトとパラメータを入力する

プロンプトとパラメータを入力します。今回は以下のようなスーパーカーを生成するプロンプトを使用しました。

Urban landscape, one supercar.パラメータの設定方法は、以下の記事で解説しています。

プロンプトの作成が難しいと思われている方には、AIでプロンプトを自動生成するのがおすすめです。「StableDiffusionのプロンプト(呪文)を自然言語処理モデルGPT-3(Catchy)で自動生成する方法」で詳細を解説しています。

画像生成を実行する

Genarateボタンをクリックすると画像が生成されます。

以下のように画像が生成されました。

Stable Diffusionのテクニックを効率よく学ぶには?

カピパラのエンジニア

カピパラのエンジニアStable Diffusionを使ってみたいけど、ネットで調べた情報を試してもうまくいかない…

そんな時は、操作方法の説明が動画で見られるUdemyがおすすめだよ!

動画学習プラットフォームUdemyでは、画像生成AIで高品質なイラストを生成する方法や、AIの内部で使われているアルゴリズムについて学べる講座が用意されています。

Udemyは講座単体で購入できるため安価で(セール時1500円くらいから購入できます)、PCが無くてもスマホでいつでもどこでも手軽に学習できます。

Stable Diffusionに特化して学ぶ

Stable Diffusionに特化し、クラウドコンピューティングサービスPaperspaceでの環境構築方法から、モデルのマージ方法、ControlNetを使った構図のコントロールなど、中級者以上のレベルを目指したい方に最適な講座です。

画像生成AIの仕組みを学ぶ

画像生成AIの仕組みについて学びたい方には、以下の講座がおすすめです。

画像生成AIで使用される変分オートエンコーダやGANのアーキテクチャを理解することで、よりクオリティの高いイラストを生成することができます。

まとめ

今回はStable Diffusion 2.1をWebUI上で動作させる方法について解説しました。

主にフォトリアル系の風景などでは非常にクオリティの高い画像が生成できますので、ぜひ活用してみてください。

また、以下の記事で効率的にPythonのプログラミングスキルを学べるプログラミングスクールの選び方について解説しています。最近ではほとんどのスクールがオンラインで授業を受けられるようになり、仕事をしながらでも自宅で自分のペースで学習できるようになりました。

スキルアップや副業にぜひ活用してみてください。

スクールではなく、自分でPythonを習得したい方には、いつでもどこでも学べる動画学習プラットフォームのUdemyがおすすめです。

講座単位で購入できるため、スクールに比べ非常に安価(セール時1200円程度~)に学ぶことができます。私も受講しているおすすめの講座を以下の記事でまとめていますので、ぜひ参考にしてみてください。

コメント