今回は、2023年9月現在にリリースされているStable Diffusionで利用可能な最新のモデルについて解説します。

今月もStability AI公式のSDXL1.0をベースとしたハイクオリティなモデルを多く紹介しますが、2次元モデルではまだまだSD1.5系のクオリティが高いため、こちらもあわせて紹介します。

- 2023年9月現在のStable Diffusionおすすめ最新モデル

- 各モデルで生成できる画像サンプル

- 各モデルの入手先

- WebUIでモデルを設定する方法

今回紹介するモデル以外にも過去にリリースされたモデルを以下の記事で紹介しています。

また、当ブログのStable Diffusionに関する記事を以下のページでまとめていますので、あわせてご覧ください。

Stable Diffusionの導入方法から応用テクニックまでを動画を使って習得する方法についても以下のページで紹介しています。

Stable Diffusionとは

Stable Diffusion(ステーブル・ディフュージョン)は2022年8月に無償公開された描画AIです。ユーザーがテキストでキーワードを指定することで、それに応じた画像が自動生成される仕組みとなっています。

NVIDIAのGPUを搭載していれば、ユーザ自身でStable Diffusionをインストールし、ローカル環境で実行することも可能です。

(出典:wikipedia)

SDXLの超軽量GUI Fooocus

SDXLをベースとしたモデルは、非常に多くのVRAMを使用するため、ハイスペックなグラフィックボードを必要とします。

VRAMの容量の制約でSDXLが実行できる環境がない方には、最小4GBのVRAMでも動作する軽量GUIであるFooocusでSDXLベースモデルを使用することをお勧めします。

Stable DiffusionのWeb UI AUTOMATIC1111

AUTOMATIC1111はStable Diffusionをブラウザから利用するためのWebアプリケーションです。

AUTOMATIC1111を使用することで、プログラミングを一切必要とせずにStable Diffusionで画像生成を行うことが可能になります。

Web UI AUTOMATIC1111のインストール方法

Web UIであるAUTOMATIC1111を実行する環境は、ローカル環境(自宅のゲーミングPCなど)を使用するか、クラウドコンピューティングサービスを利用する2通りの方法があります。

以下の記事ではそれぞれの環境構築方法について詳し解説していますので、合わせてご覧ください。

2023年9月最新モデル紹介

BlazingRealDrive(9/7追加)

アニメ系モデルで人気のBreakシリーズの製作者である、BDさんの初のフォトリアル系モデル(SD1.5ベース)がリリースされました。

アジア系の美少女を生成できるモデルです。特に日本人風の人物を生成するモデルの中では、トップクラスのクオリティですので、AIコスプレイヤーなどの画像を生成したい方に最適です。

なお、VRAM使用量が大きいため、アップスケールにはMultiDiffusionがおすすめです。

配布先

CounterfeitXL

CounterfeitXLはEasyNegativeの製作者であるgsdfさんが公開されているアニメ調モデルです。SDXLをベースとしており、ハイクオリティなキャラクターと精細な背景を両立しています。

配布先

プロンプトの作成が難しいと思われている方には、AIでプロンプトを自動生成するのがおすすめです。「StableDiffusionのプロンプト(呪文)を自然言語処理モデルGPT-3(Catchy)で自動生成する方法」で詳細を解説しています。

Cherry Picker XL

SDXLをベースとしたフォトリアル系モデルです。推奨解像度は768×768以上で、それ以下の解像度では画質が悪くなるとのことです。

アジア人特化のモデルではありませんが、プロンプトにJapanese idleなどのキーワードを加えることで、日本人風のハイクオリティな人物を描画することができます。

配布先

Kohaku-XL

Kohaku-XLはSDXLをベースにいくつかのアニメ調モデルをマージして作成されたもでるです。追加で160万枚の画像を使用してトレーニング中とのことで、2023年8月現在α版となっています。

txt2imgで1024×1536 での大サイズでの画像生成にも対応しています。

配布先

Negi-Mix

Shungiku-Mix製作者であるVすき焼きさんの2023年9月現在公開されている最新モデルNegi-Mixです。ベースモデルはSD1.5となります。

壮大で精細な背景が描画できるモデルです。VAEは不要です。

配布先

WebUIでのモデルの設定

モデルの設定方法

ダウンロードしたモデルをStable Diffusionのディレクトリに配置します。

実行環境により配置方法が異なりますので、ご利用の環境の項目を参考にしてください。

ローカル環境

ローカル環境で使用する場合は、ローカルPCの以下のディレクトリにモデルファイルを配置してください。

Google Colaboratory

Google Colaboratoryでモデルファイルを配置するディレクトリは以下となります。

Google Colaboratoryの場合は毎回モデルをダウンロードする必要がありますので、自動でダウンロードされるよう以下のコマンドを追加します。

!wget https://civitai.com/api/download/models/15980 -O /content/stable-diffusion-webui/models/Stable-diffusion/museV1_v1.safetensors詳細な追加方法については以下の記事で解説しています。

Paperspace

Paperspaceで使用する場合は、Paperspaceの仮想マシンの以下のディレクトリにモデルファイルを配置してください。

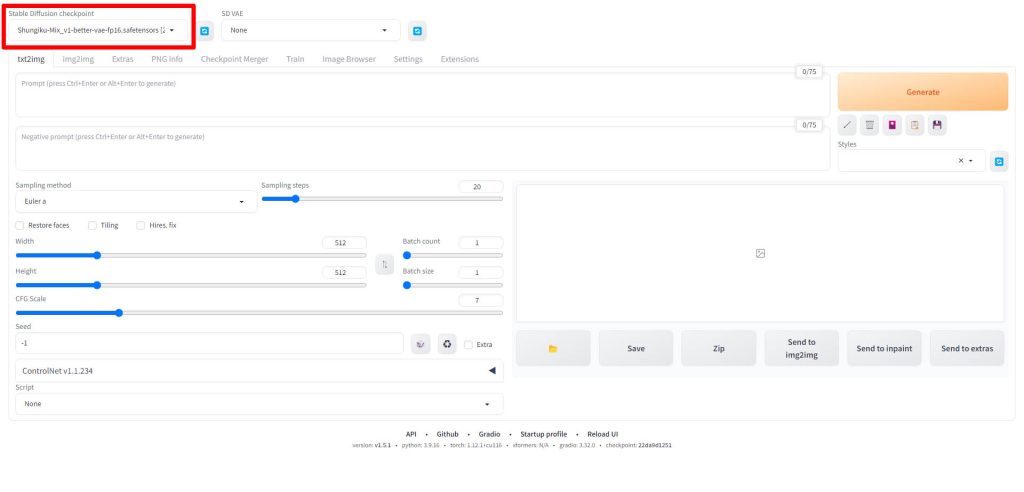

モデルの選択方法

モデルファイルを配置したら、WebUIのを起動します。

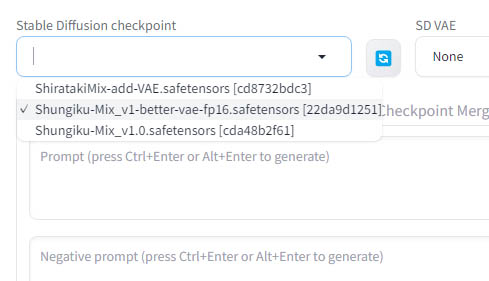

WebUIの画面左上のStable Diffusion checkpointと書かれている項目が、画像生成に使用されるモデルを指定する項目となります。

Stable Diffusion checkpointのドロップダウンリストをクリックすると、先ほどのモデルファイルを配置したディレクトリにあるファイルが一覧で表示されますので、使用したいモデルを選択してください。

以上でモデルの設定は完了です。

VAEの紹介と設定方法

Stable Diffusionで画像生成する際に、今回紹介したような学習済みモデルと合わせてVAE(Variational Auto Encoder)が必要となります。

おすすめのVAEの紹介と、設定方法を以下の記事で解説していますので、あわせてご覧ください。。

2023年9月以外のモデル情報

2023年9月以外の新、旧モデル情報は以下の記事で紹介しています。

Stable Diffusionのテクニックを効率よく学ぶには?

カピパラのエンジニア

カピパラのエンジニアStable Diffusionを使ってみたいけど、ネットで調べた情報を試してもうまくいかない…

そんな時は、操作方法の説明が動画で見られるUdemyがおすすめだよ!

動画学習プラットフォームUdemyでは、画像生成AIで高品質なイラストを生成する方法や、AIの内部で使われているアルゴリズムについて学べる講座が用意されています。

Udemyは講座単体で購入できるため安価で(セール時1500円くらいから購入できます)、PCが無くてもスマホでいつでもどこでも手軽に学習できます。

Stable Diffusionに特化して学ぶ

Stable Diffusionに特化し、クラウドコンピューティングサービスPaperspaceでの環境構築方法から、モデルのマージ方法、ControlNetを使った構図のコントロールなど、中級者以上のレベルを目指したい方に最適な講座です。

画像生成AIの仕組みを学ぶ

画像生成AIの仕組みについて学びたい方には、以下の講座がおすすめです。

画像生成AIで使用される変分オートエンコーダやGANのアーキテクチャを理解することで、よりクオリティの高いイラストを生成することができます。

まとめ

今回は、2023年9月現在のStable Diffusionで使用できる最新モデルについて紹介しました。

Stability AI公式のSDLXベースモデルに加えて、SD1.5系でも著名なモデル製作者さんからNAIフリーのモデルが徐々にリリースされ始めています。

Stable Diffusionでの画像生成にぜひ活用してみてください。

また、以下の記事で効率的にPythonのプログラミングスキルを学べるプログラミングスクールの選び方について解説しています。最近ではほとんどのスクールがオンラインで授業を受けられるようになり、仕事をしながらでも自宅で自分のペースで学習できるようになりました。

スキルアップや副業にぜひ活用してみてください。

スクールではなく、自分でPythonを習得したい方には、いつでもどこでも学べる動画学習プラットフォームのUdemyがおすすめです。

講座単位で購入できるため、スクールに比べ非常に安価(セール時1200円程度~)に学ぶことができます。私も受講しているおすすめの講座を以下の記事でまとめていますので、ぜひ参考にしてみてください。

それでは、また次の記事でお会いしましょう。

コメント