これまでStable Diffusionを使ってアニメ調のイラストを生成するためのノウハウと紹介してみましたが、今回はリアル系のイラストを生成する方法を解説します。

リアル系もクオリティの高いマージモデルやLoRAファイルが多数公開されています。

AUTOMATIC1111の環境を構築済みの方であれば、モデルを入れ替えるだけで生成できますので、ぜひ試してみてください。

Stable Diffusionモデルを入れ替えるだけでリアル系のイラストが作成可能。

また、当ブログのStable Diffusionに関する記事を以下のページでまとめていますので、あわせてご覧ください。

Stable Diffusionの導入方法から応用テクニックまでを動画を使って習得する方法についても以下のページで紹介しています。

Stable Diffusionとは

Stable Diffusion(ステーブル・ディフュージョン)は2022年8月に無償公開された描画AIです。ユーザーがテキストでキーワードを指定することで、それに応じた画像が自動生成される仕組みとなっています。

NVIDIAのGPUを搭載していれば、ユーザ自身でStable Diffusionをインストールし、ローカル環境で実行することも可能です。

(出典:wikipedia)

Stable DiffusionのWeb UI AUTOMATIC1111

AUTOMATIC1111はStable Diffusionをブラウザから利用するためのWebアプリケーションです。

AUTOMATIC1111を使用することで、プログラミングを一切必要とせずにStable Diffusionで画像生成を行うことが可能になります。

Web UI AUTOMATIC1111のインストール方法

Web UIであるAUTOMATIC1111を実行する環境は、ローカル環境(自宅のゲーミングPCなど)を使用するか、クラウドコンピューティングサービスを利用する2通りの方法があります。

以下の記事ではそれぞれの環境構築方法について詳し解説していますので、合わせてご覧ください。

モデルを入手する

Stable Diffusionの環境を構築したら、次はリアル系のイラストを描画できる学習済みモデルを入手します。

使用するモデル MUSE_v1

今回はMUSE_v1というリアル系の画像を生成できるモデルを使用します。

配布先ページは以下となります。VAEは不要です。

モデルの設定方法

ダウンロードしたモデルをStable Diffusionのディレクトリに配置します。

実行環境により配置方法が異なりますので、ご利用の環境の項目を参考にしてください。

ローカル環境

ローカル環境で使用する場合は、ローカルPCの以下のディレクトリにモデルファイルを配置してください。

Google Colaboratory

Google Colaboratoryでモデルファイルを配置するディレクトリは以下となります。

Google Colaboratoryの場合は毎回モデルをダウンロードする必要がありますので、自動でダウンロードされるよう以下のコマンドを追加します。

!wget https://civitai.com/api/download/models/15980 -O /content/stable-diffusion-webui/models/Stable-diffusion/museV1_v1.safetensors詳細な追加方法については以下の記事で解説しています。

Paperspace

Paperspaceで使用する場合は、Paperspaceの仮想マシンの以下のディレクトリにモデルファイルを配置してください。

モデルの選択方法

モデルファイルを配置したら、WebUIのを起動します。

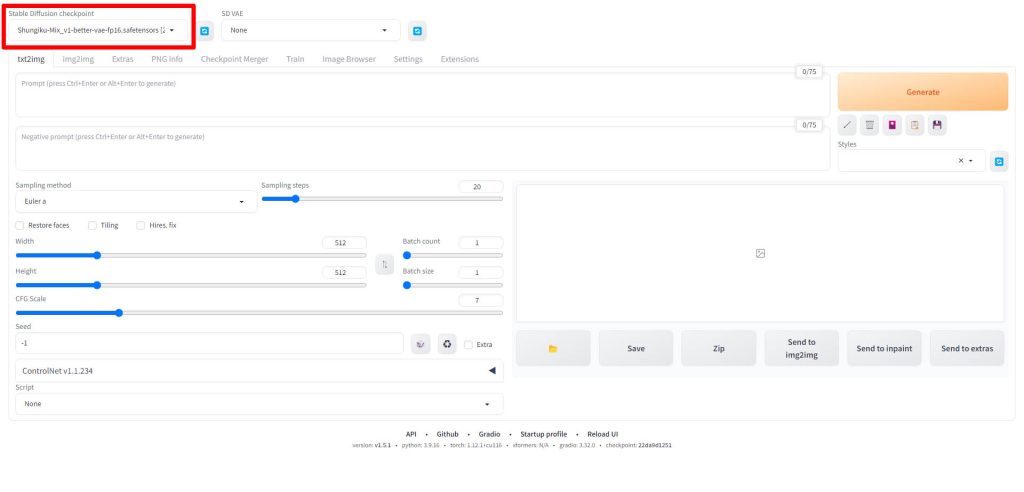

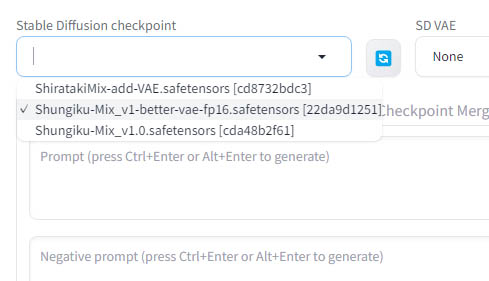

WebUIの画面左上のStable Diffusion checkpointと書かれている項目が、画像生成に使用されるモデルを指定する項目となります。

Stable Diffusion checkpointのドロップダウンリストをクリックすると、先ほどのモデルファイルを配置したディレクトリにあるファイルが一覧で表示されますので、使用したいモデルを選択してください。

以上でモデルの設定は完了です。

画像を生成する

今回は以下のようなプロンプトを用意しました。

プロンプト

ポジティブプロンプトは以下となります。「(photo realistic:1.4)」など、リアル系のイラスト特有のキーワードを入れています。

((masterpiece:1.4, best quality)), ((masterpiece, best quality)), (photo realistic:1.4) ((1girl)), (ultra highres:1.2), Japanese idle , Japanese actress ,very cute, outdoorsネガティブプロンプト

ネガティブプロンプトは以下となります。こちらも人間の肌に関する描写などのキーワードがアニメ系とは異なります。

Easy Negative (worst quality:2) (low quality:2) (normal quality:2) lowers normal quality ((monochrome)) ((grayscale)),skin spots,acnes,skin blemishes,age spot,ugly face,fat,missing fingers, extra fingers, extra arms,open chest,thick eyebrows, open chest実行結果

MUSE_v1で先ほどのプロンプトを使って生成した画像がこちらです。

日本人っぽい綺麗な女の子のイラストを生成することができました。

LoRAで人物を固定して生成する

Stable Diffusionでは、追加学習LoRAを使用することで、人物を固定して様々な構図やポーズ、髪型、衣装を変えて生成することが可能です。

LoRAの使い方は以下の記事で解説しています。

Stable Diffusionリアル系モデル紹介

今回紹介したMUSE_v1以外にも、ハイクオリティなリアル系マージモデルはWeb上でたくさん公開されています。MUSE_v1以外のモデルについては以下の記事で解説していますので、あわせてご覧ください。

Stable Diffusionのテクニックを効率よく学ぶには?

カピパラのエンジニア

カピパラのエンジニアStable Diffusionを使ってみたいけど、ネットで調べた情報を試してもうまくいかない…

そんな時は、操作方法の説明が動画で見られるUdemyがおすすめだよ!

動画学習プラットフォームUdemyでは、画像生成AIで高品質なイラストを生成する方法や、AIの内部で使われているアルゴリズムについて学べる講座が用意されています。

Udemyは講座単体で購入できるため安価で(セール時1500円くらいから購入できます)、PCが無くてもスマホでいつでもどこでも手軽に学習できます。

Stable Diffusionに特化して学ぶ

Stable Diffusionに特化し、クラウドコンピューティングサービスPaperspaceでの環境構築方法から、モデルのマージ方法、ControlNetを使った構図のコントロールなど、中級者以上のレベルを目指したい方に最適な講座です。

画像生成AIの仕組みを学ぶ

画像生成AIの仕組みについて学びたい方には、以下の講座がおすすめです。

画像生成AIで使用される変分オートエンコーダやGANのアーキテクチャを理解することで、よりクオリティの高いイラストを生成することができます。

まとめ

今回はStable Diffusionでリアル系のイラストを生成する方法について解説しました。リアル系のモデルやプロンプトエンジニアリングについてさらに解説記事を作成していく予定です。

また、以下の記事で効率的にPythonのプログラミングスキルを学べるプログラミングスクールの選び方について解説しています。最近ではほとんどのスクールがオンラインで授業を受けられるようになり、仕事をしながらでも自宅で自分のペースで学習できるようになりました。

スキルアップや副業にぜひ活用してみてください。

スクールではなく、自分でPythonを習得したい方には、いつでもどこでも学べる動画学習プラットフォームのUdemyがおすすめです。

講座単位で購入できるため、スクールに比べ非常に安価(セール時1200円程度~)に学ぶことができます。私も受講しているおすすめの講座を以下の記事でまとめていますので、ぜひ参考にしてみてください。

コメント